Les gouvernements utilisent-ils l’IA comme une arme pour remodeler le discours public et blanchir leurs crimes ?

Les lanceurs d’alerte de l’organisation Integrity de Meta ont partagé des données avec International Corruption Watch (ICW), révélant des preuves d’une stratégie de censure de masse abusant du système de signalement de Meta.

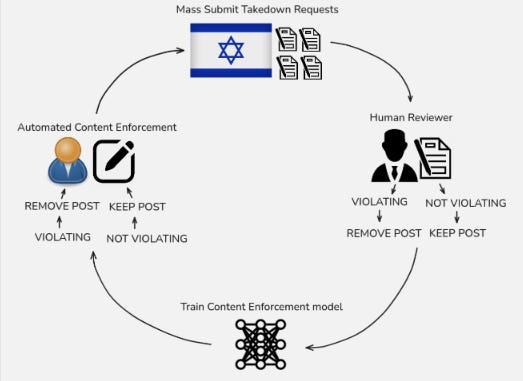

- Rapports d’utilisateur : tout utilisateur de Facebook peut signaler une publication.

- Contrôle par IA : la publication est d’abord vérifiée par un modèle d’IA chargé de l’application du contenu, qui examine le texte et les médias associés. Si le modèle est sûr, il supprime la publication.

- Examen humain : si le modèle n’est pas fiable, le rapport sera transmis à un examinateur humain.

- Boucle d’entraînement : si un humain approuve le retrait, la publication est étiquetée comme un élément de données d’entraînement et renvoyée à l’ensemble de données d’entraînement de l’IA, permettant au modèle de s’adapter en temps réel.

La description publique de ce pipeline par Meta est disponible à l’adresse https://transparency.meta.com/enforcement/detecting-violations/how-enforcement-technology-works .

Prioriser les demandes gouvernementales

Les gouvernements et les entités privilégiées disposent d’un accès privilégié pour soumettre des demandes de retrait. Ces demandes sont prioritaires et transmises directement aux examinateurs. Elles peuvent être soumises par formulaire ou par e-mail à Meta, selon le pays concerné.

Ces rapports sont traités plus rapidement et sont plus susceptibles d’être supprimés. De même, une fois approuvés par un humain, ils reçoivent une étiquette et sont ajoutés à l’ensemble de données d’entraînement.

Lorsque de grandes quantités de demandes soumises par le gouvernement sont approuvées, le modèle d’IA reçoit un flot d’exemples étiquetés sur lesquels il s’entraîne davantage.

En cas d’abus, il s’agit d’un exemple d’attaque par apprentissage automatique appelée « empoisonnement des données ». Le modèle finit par être fortement biaisé et tend à supprimer le contenu correspondant aux modèles de signalement.

Enquête de l’International Corruption Watch

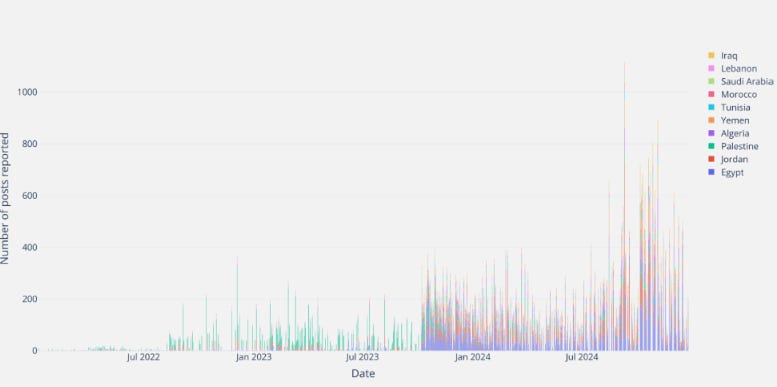

L’ICW émet l’hypothèse que des gouvernements comme Israël utilisent la couverture médiatique massive en temps de crise pour influencer l’opinion publique. Dans ce rapport, l’ICW a agrégé des données puis analysé les demandes de retrait du gouvernement israélien.

Avant l’attaque du 7 octobre, le gouvernement israélien recevait en moyenne une centaine de signalements par jour. Après l’attaque, ce volume a grimpé en flèche, atteignant 150 à 400 signalements par jour.

Que contient un rapport

Chaque signalement est associé au pays d’origine du message. Contrairement à d’autres pays, les données montrent qu’Israël s’est concentré sur les messages provenant des pays voisins, comme l’Égypte, la Jordanie, la Palestine, l’Algérie et le Yémen. Ces quelques pays voisins ont représenté 69 % des signalements. Les signalements israéliens de messages provenant des États-Unis n’ont représenté que 0,7 % du volume total des signalements.

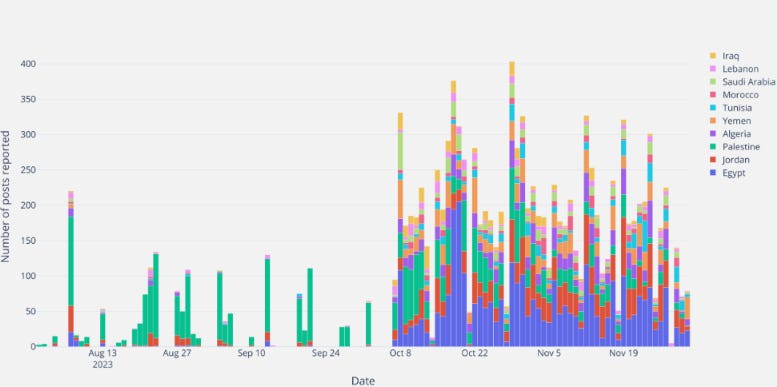

Le timing

En zoomant, on constate que l’activité s’est intensifiée après le 7 octobre, l’attention s’étant déplacée de la Palestine vers la région environnante. Il convient également de noter la baisse des signalements tous les sept jours, coïncidant avec le Shabbat.

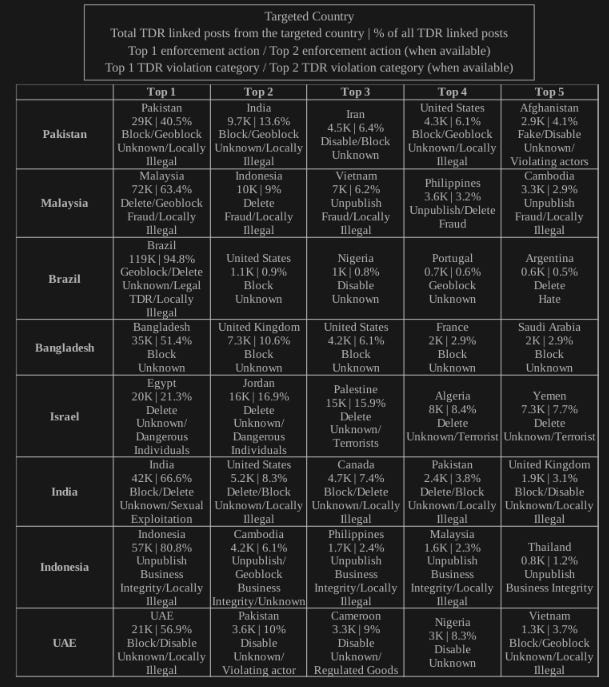

Bien qu’Israël soit le pays qui reçoit le plus de demandes de retrait par habitant, d’autres gouvernements envoient également un grand nombre de rapports, notamment le Pakistan, la Malaisie, le Brésil, le Bangladesh, l’Inde, l’Indonésie et les Émirats arabes unis.

Il est remarquable que ces pays se concentrent sur la suppression des publications au sein de leur propre pays et pour des catégories de suppression assez différentes (« localement illégales »).

Voici un graphique du rapport montrant les principaux pays déclarants par rapport aux nations pour lesquelles ils ont déclaré :

Un peu de poison pour vos données

L’équipe de l’ICW a examiné la corrélation entre tous les signalements automatiquement signalés comme « terroristes » par l’IA de Meta, dans tous les pays. Comme vous pouvez le constater, un pic important a suivi le 7 octobre. Cela suggère un surapprentissage du modèle.

L’IA de Meta est devenue hypersensible à tout contenu contenant des images d’actualité ou des discussions sur la Palestine, ce qui a conduit à une suppression à grande échelle dans le monde entier.

Cela équivaut à censurer le contenu dans tous les pays en même temps.

Ctrl C À plus tard

Selon le rapport de l’ICW, le gouvernement israélien a soumis un modèle unique pour chaque demande de retrait. Ce modèle contenait :

- Une description de l’attaque du 7 octobre et un compte rendu officiel israélien

- Citations des lois antiterroristes israéliennes

- Liens vers plusieurs publications signalées

Le rapport allègue que des demandes identiques ont été envoyées des dizaines de milliers de fois sans aucun contexte ni raisonnement supplémentaire pour chaque publication unique.

Les données indiquent que Meta a approuvé ces rapports dans 94 % des cas, avec une révision humaine moyenne de 30 secondes. Ce taux d’approbation est bien plus élevé et plus rapide que dans d’autres pays.

Cela suggère qu’il existe un biais inhabituel en faveur des rapports d’origine israélienne.

Échelle de l’impact

L’ICW estime qu’environ 38,8 millions de publications ont été traitées suite à l’empoisonnement des données du modèle de contrôle du contenu. Ces publications ont été supprimées non pas parce qu’elles enfreignaient la politique, mais parce que le modèle était sur-entraîné par les signalements massifs du gouvernement.

Le rapport de l’ICW pourrait bénéficier d’une analyse antérieure de Human Rights Watch, qui a montré qu’Israël recourait à des reportages de masse pour réprimer les critiques en signalant des publications comme du « spam ». Meta a ensuite reconnu cette censure involontaire et présenté des excuses.

Conclusion

Cela indique un nouveau paradigme de censure assistée par l’IA où une boucle de rétroaction est utilisée :

Rapports gouvernementaux privilégiés et volumineux —> Approbation humaine rapide —> Recyclage de l’IA —> IA réglée pour censurer un contenu similaire

Lorsque les entrées de contenu de l’IA sont manipulées et acceptées, le biais de modèle qui en résulte peut faire taire le discours légitime.

Il serait extrêmement inquiétant que les gouvernements utilisent l’IA comme une arme pour remodeler le discours public et blanchir leurs crimes.

Ce type d’activité n’étant pas nouveau et ayant été reconnu par Meta, il est peu probable que nous assistions un jour à une modération équitable sur une grande plateforme. Des plateformes décentralisées alternatives sont absolument nécessaires.

Quels types de médias sociaux voyez-vous devenir populaires à l’avenir ?

Les médias sociaux devraient-ils être modérés par l’IA ?

Ce problème aurait-il été atténué si l’examen humain avait fait son travail ?

Il s’agit d’un segment de l’épisode 10 de #TBOT Show. Regardez l’épisode complet ici !